연기가 자욱해 앞이 안보이는 재난 상황에서 별도의 시각이나 촉각 센서의 도움 없이 계단을 오르내리고 나무뿌리와 같은 울퉁불퉁한 환경 등에서 넘어지지 않고 움직이는 사족보행 로봇 기술이 국내 연구진에 의해 개발됐다.

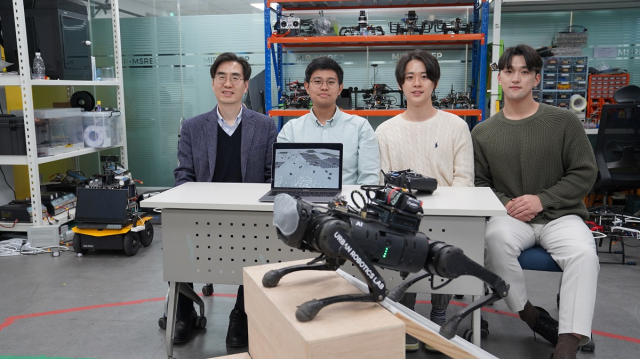

KAIST는 전기및전자공학부 명현 교수 연구팀(미래도시 로봇연구실)이 다양한 비정형 환경에서도 강인한 ‘블라인드 보행(blind locomotion)’을 가능케 하는 보행 로봇 제어 기술을 개발했다고 29일 밝혔다.

연구팀은 사람이 수면 중 깨어서 깜깜한 상태에서 화장실을 갈 때 시각적인 도움이 거의 없이 보행이 가능한 것처럼 블라인드 보행이 가능하다고 해서 붙여진 ‘드림워크(DreamWaQ)’기술을 개발했고 이 기술이 적용된 로봇을 ‘드림워커(DreamWaQer)’라고 명명했다. 즉 이 기술을 탑재하면 다양한 형태의 사족보행 로봇 드림워커를 만들어낼 수 있게 된다.

기존 보행 로봇 제어기는 기구학 또는 동역학 모델을 기반으로 한다. 이를 모델 기반 제어 방식이라고 표현하는데 특히 야지와 같은 비정형 환경에서 안정적인 보행을 하기 위해서는 모델의 특징 정보를 더욱 빠르게 얻을 수 있어야 한다. 그러나 이는 주변 환경의 인지 능력에 많이 의존하는 모습을 보여 왔다.

반면 명현 교수 연구팀이 개발한 인공지능 학습 방법 중 하나인 심층 강화학습 기반의 제어기는 시뮬레이터로부터 얻어진 다양한 환경의 데이터를 통해 보행 로봇의 각 모터에 적절한 제어 명령을 빠르게 계산해 줄 수 있다.

시뮬레이션에서 학습된 제어기가 실제 로봇에서 잘 작동하려면 별도의 튜닝 과정이 필요했다면 연구팀이 개발한 제어기는 별도의 튜닝을 요구하지 않는다는 장점도 있어 다양한 보행 로봇에 쉽게 적용될 수 있을 것으로 기대된다.

연구팀이 개발한 제어기인 드림워크는 크게 지면과 로봇의 정보를 추정하는 상황(context) 추정 네트워크와 제어 명령을 산출하는 정책(policy) 네트워크로 구성된다. 상황추정 네트워크는 관성 정보와 관절 정보들을 통해 암시적으로 지면의 정보를, 명시적으로 로봇의 상태를 추정한다. 이 정보는 정책 네트워크에 입력돼 최적의 제어 명령을 산출하는 데 사용된다. 두 네트워크는 시뮬레이션에서 함께 학습된다.

상황추정 네트워크는 지도학습을 통해 학습되는 반면, 정책 네트워크는 심층 강화학습 방법론인 행동자-비평자(actor-critic) 방식을 통해 학습된다. 행동자 네트워크는 주변 지형 정보를 오직 암시적으로 추정할 수 있다. 시뮬레이션에서는 주변 지형 정보를 알 수 있는데, 지형 정보를 알고 있는 비평자 네트워크가 행동자 네트워크의 정책을 평가한다.

이 모든 학습 과정에는 단 1시간 정도만 소요되며 실제 로봇에는 학습된 행동자 네트워크만 탑재된다. 주변 지형을 보지 않고도 오직 로봇 내부의 관성 센서(IMU)와 관절 각도의 측정치를 활용해 시뮬레이션에서 학습한 다양한 환경 중 어느 환경과 유사한지 상상하는 과정을 거친다. 갑자기 계단과 같은 단차를 맞이하는 경우, 발이 단차에 닿기 전까지는 알 수 없지만 발이 닿는 순간 빠르게 지형 정보를 상상한다. 그리고 이렇게 추측된 지형 정보에 알맞은 제어 명령을 각 모터에 전달해 재빠른 적응 보행이 가능하다.

드림워커(DreamWaQer) 로봇은 실험실 환경뿐 아니라 연석과 과속방지턱이 많은 대학 캠퍼스 환경, 나무뿌리와 자갈이 많은 야지 환경 등에서 보행 시 지면으로부터 몸체까지 높이의 3분의 2정도의 계단 등을 극복함으로써 강인한 성능을 입증했다. 또한 환경과 무관하게, 0.3m/s의 느린 속도부터 1.0m/s의 다소 빠른 속도까지도 안정적인 보행이 가능함을 연구팀은 확인했다.

이번 연구 결과는 이 마데 아스윈 나렌드라(I Made Aswin Nahrendra) 박사과정이 제1 저자로, 유병호 박사과정이 공동 저자로 참여했다. 오는 5월 말 영국 런던에서 개최되는 로보틱스 분야의 세계 최고 권위 학회인 ‘ICRA(IEEE International Conference on Robotics and Automation)’에 채택되어 발표될 예정이다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

hypark@sedaily.com

hypark@sedaily.com