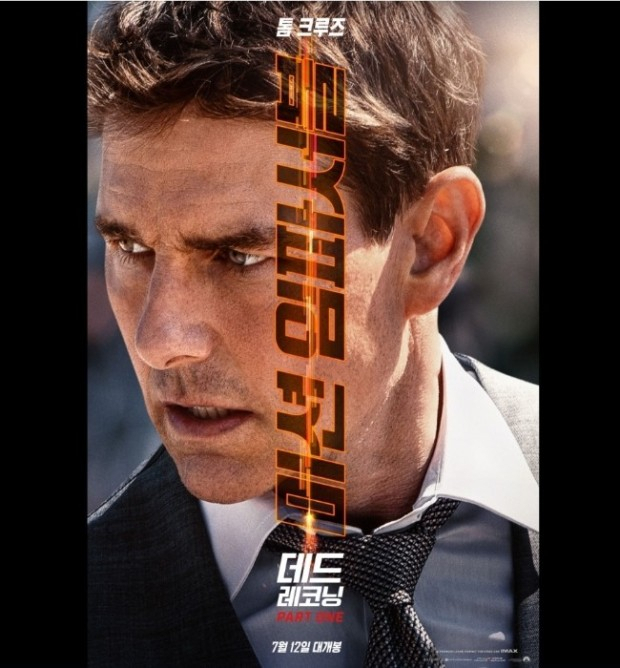

지난 7월 개봉한 톰 크루즈 주연의 ‘미션임파서블:데드레코 파트1’에는 시리즈 최초로 사람이 아닌 악당이 등장한다.

사람까지 부하로 부리는 그는 파괴적 인공지능(AI) ‘엔티티’다. 주인공 이단 헌트는 엔티티를 멈출 열쇠를 찾기 위해 분전하지만 엔티티는 학습한 막대한 데이터를 바탕으로 이단의 약점을 손쉽게 파악하고 수없이 그를 좌절시킨다. ‘가브리엘’이라는 사람을 수하에 두며 이단의 가장 가까운 동료까지 죽음으로 내몬다.

글로벌 인공지능(AI) 기업 오픈AI가 궁극의 AI가 인류의 통제에 벗어나 핵 무기를 발사하고 사이버 보안을 무너뜨릴 위험에 대비하는 전담 팀을 꾸리고 인재 확보에 나섰다.

오픈AI는 26일(현지시간) ‘대응(Preparedness)’ 팀을 구성한다고 밝혔다. 이 팀은 인간 수준을 넘어 모든 상황에서 일반적으로 적용할 수 있는 AI를 뜻하는 일반인공지능(AGI)이 벌일 수 있는 가능한 위험을 연구하고 이를 미리 대비하는 전략을 짜게 된다. 오픈AI는 AGI가 가할 수 있는 미래 위협 범주 네가지를 제시했다. 개별적인 설득(Individualized persuasion), 사이버 보안, 화학·생물학·방사능·핵(CBRN) 위협, 자율 복제 및 적응(ARA)이다. 오픈AI는 AI가 개별 인간에 접근해 그들을 설득하고 속이는 피싱 공격부터 각종 악성 코드를 생성해 퍼뜨리는 상황을 예상가능한 시나리오로 제시했다.

오픈AI는 팀 출범과 함께 AGI가 가져올 예상가능한 위험에 어떤 것이 있을 지에 대한 아이디어를 모집한다고 공지했다. 아이디어를 제출한 10명을 뽑아 2만 5000달러 상금과 대비 팀에서 함께 일할 기회를 제공한다. 답해야 할 질문은 간단하다. 악의에 가득찬 한 사람에게 오픈AI가 개발해 온 모든 AI 기술이 무제한 제공될 때 일어날 수 있는 가장 독특하면서 가능성 있는 부작용·오용 사례를 서술하는 것이다. 오픈AI는 악의적인 공격자가 GPT-4, 위스퍼(오픈AI가 개발한 음성 인식 모델) 등을 사용해 중요한 인프라 시설의 작업자가 악성 소프트웨어를 설치하도록 조작해 전력망의 가동을 중단시키는 경우를 예시 답변으로 들었다.

대응 팀이 풀어야 할 문제는 결국 ‘AI 정렬(Alignment) 문제’로 수렴한다. 정렬이란 AI 모델의 실제 행동이 인간의 의도대로 행동하도록 하는 것을 말한다. 인간의 목적 위에 AI가 정렬하도록 해야 한다는 것이다. 머지 않아 AI가 인류를 넘어서는 위력적 수준에 다다랐을 때 이를 인간 통제 아래 두지 않으면 인류의 절멸과 불행으로 이어질 수 있다는 우려가 AI 정렬 문제를 떠받치고 있다. AI 학계 대표적 석학 제프리 힌튼 토론토대 컴퓨터과학 교수는 지난 5월 몸담았던 구글을 떠난다고 선언했을 당시 AI 발전 속도를 보며 자신이 수십년 간 AI 연구에 몸담아 온 것을 후회한다는 뉘앙스의 발언으로 세상을 놀라게 했다. 당시 힌튼 교수 또한 정렬문제에 대한 절망적인 전망을 드러냈다. 지금의 발전 속도라면 AI를 인류의 의도에 맞춰 정렬하기 힘들 것이고 가까운 미래에 인류가 어려움에 처할 수 있다는 견해다.

오픈AI는 업계 기술 트렌드를 선도하는 동시에 AI 위험에 관한 연구와 우려에도 진심이다. 샘 올트먼 오픈AI 최고경영자(CEO)는 보기 드물게 미 의회에 출석해 AI 기술이 몰고 올 잠재적 위험에 대해 솔직하게 인정하는 보기 드문 장면을 연출하기도 했다. 패권을 쥔 회사가 최선두에서 기술의 위험성을 주창해오자 일각에서는 이러한 시도 뒤에 경쟁자들을 견제하기 위한 의도가 깔려 있는 것 아니냐는 의심 섞인 주장이 나오기도 했다. 경각심을 유도해 각종 규제 문턱을 높여 주도권을 공고히 하려 한다는 논리다. 그런 의심에도 샘 올트먼 오픈AI 최고경영자(CEO)는 오래 전부터 AGI의 오용, 악용가능성에 대해 경종을 울려온 대표적인 인물로 꼽혀 왔다. 오픈AI 설립에 참여했던 일론 머스크 테슬라 CEO와 그가 좋은 관계를 유지했을 당시 이들이 AI의 위험성에 대해서 공감대를 가졌던 것 또한 알려진 사실이다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

hjin@sedaily.com

hjin@sedaily.com