오픈AI와 손잡은 마이크로소프트(MS)가 소형 생성형 인공지능(AI) ‘파이-3 미니’를 공개했다. 최근 메타가 신형 소형언어모델(SLM) ‘라마3’를 공개한 데 대한 MS의 대답이다. 앞서 구글 또한 초거대 AI ‘제미나이’와 함께 소형 모델 ‘젬마’를 선보인 바 있다. 초거대 AI에서 시작된 AI 경쟁의 전선이 작고 효율적인 소형 AI까지 확대되는 구도다.

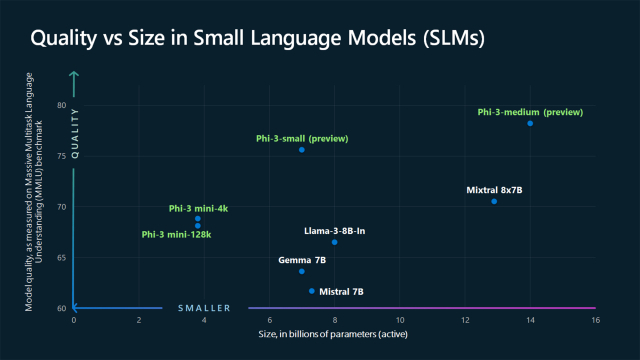

23일(현지 시간) MS는 지난해 12월 선보인 파이-2의 후속작 파이-3를 공개했다. 파이-3는 AI 개발에 사용된 매개변수(파라미터) 38억 개인 ‘미니’와 70억 개의 ‘스몰’, 140억 개인 ‘미디엄’ 3가지 종류로 제작된다. 이날 MS는 그 중 최소형인 파이-3 미니를 우선 선보였다. 세바스티엔 부벡 MS 생성형 AI 연구담당 부사장은 “파이-3는 비슷한 성능을 지닌 타 모델들과 비교해 10분의 1 비용만 든다”며 “약간이 아닌 획기적인 비용 감소가 가능하다”고 강조했다. 전작보다 성능도 개선됐다. 에릭 보이드 MS 애저 AI 플랫폼 부사장은 “파이-1은 코딩, 파이-2는 추론에 중점을 둔 모델이었다”며 “파이-3는 코딩과 추론에 더욱 능숙해졌다”고 설명했다.

오픈AI와 함께 초거대 AI인 GPT 시리즈를 개발 중인 MS가 소형 AI 시장까지 동시공략에 나서는 셈이다. 이는 많은 매개변수를 투입해 만든 초거대 AI가 가동 비용이 높다는 문제를 해결하기 위한 전략이다. 초고성능 AI가 필요하지 않은 작업 환경에서는 가볍고 빠른 SLM이 더욱 효율적이라는 판단이 선 것이다. 특히 인터넷 연결 없이도 AI 연산을 수행하는 엣지(온디바이스) AI 기기가 늘어나며 저전력·고효율 AI 모델의 필요성은 더욱 높아지고 있다.

실제 최근 생성형 AI 개발사들은 거대화 경쟁보다는 고효율화에 집중하고 있다. 대표적인 사례가 메타의 ‘라마’ 시리즈다. 메타는 전작인 라마-2부터 매개변수 70억 개를 투입한 ‘라마-2 7B’ 모델을 주력으로 내세웠다. 또 이를 오픈소스화해 수많은 라마 기반 변종 AI를 낳았다. 오픈소스는 프로그램 설계도를 공개하는 방식을 뜻한다. 메타는 최근 라마-3를 공개하면서도 매개변수가 80억 개인 라마-3 8B와 700억 개인 70B를 동시에 선보이며 소형화 전략을 지속하고 있다.

MS·오픈AI와 초거대 AI 경쟁을 펼치는 중인 구글 또한 소형 AI 모델 출시를 병행하고 있다. 구글은 지난 2월 매개변수가 각각 20억 개, 70억 개에 불과한 젬마 2B와 7B를 선보였다. 오픈AI 대항마로 꼽히는 엔트로픽도 최근 출시한 초거대 AI ‘클로드3’를 규모 별로 세분화했다. 이 중 초소형 모델인 ‘하이쿠’는 오픈AI GPT-3.5보다 고성능임에도 비용은 절반 가량에 불과하다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

beherenow@sedaily.com

beherenow@sedaily.com