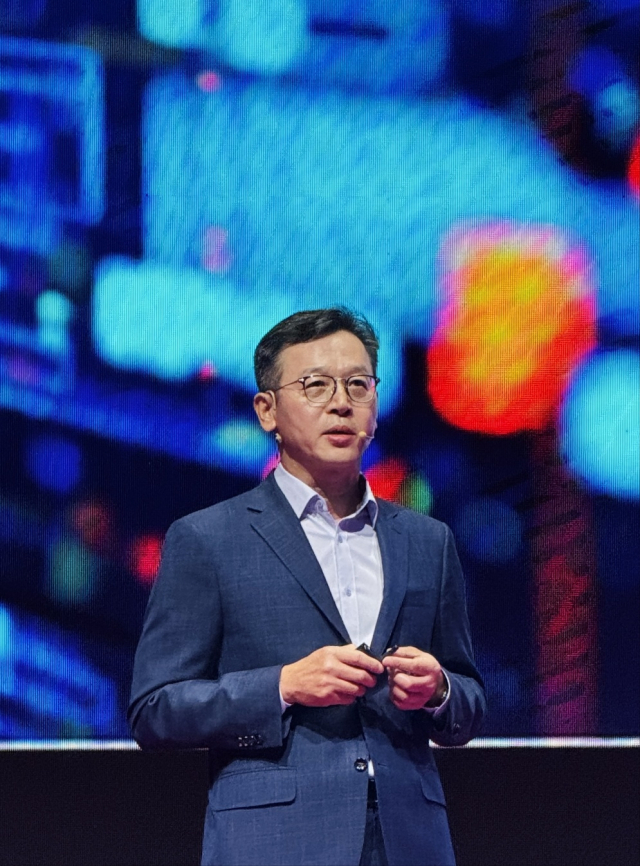

이정배 삼성전자 메모리사업부장(사장)과 김주선 SK하이닉스 인공지능(AI) 인프라 담당(사장)이 차세대 메모리 시장을 두고 대만에서 자존심 경쟁을 펼쳤다. AI 메모리의 1라운드 격인 고대역폭메모리(HBM) 시장에서는 SK하이닉스가 승기를 잡았지만 미래 메모리 시장에서는 판도가 달라질 수도 있다는 게 반도체 업계의 전망이다. 대만에서 부품사와 고객사들을 사로잡아 AI 생태계에서 한 발 더 앞서나가겠다는 청사진도 제시했다.

이 사장은 4일 대만 타이베이에서 열린 ‘세미콘 타이완 2024’에 기조연설자로 나서 “기존 메모리 공정만으로는 HBM의 성능을 높이는 데 한계가 있다”며 삼성 HBM의 강점을 집중 설명했다. 그는 “HBM 성능을 극대화하기 위해서는 로직 기술이 반드시 결합돼야 한다”며 “파운드리(반도체 위탁 생산)와 반도체 설계 능력을 동시에 갖추고 있는 삼성이 시장에서 강력한 위치를 차지하고 있다”고 강조했다.

여기서 말하는 로직 공정은 AI 가속기 내부에서 그래픽처리장치(GPU)와 D램을 연결하는 필수 부품인 로직다이(베이스다이) 생산 공정을 의미한다. 로직다이는 GPU와 메모리 사이에서 일종의 컨트롤타워 역할을 하는데 최근 AI 칩의 기능이 고도화되면서 이 부품의 기능이 점차 중요해지고 있다. 삼성은 로직다이 설계부터 생산까지 한 번에 전부 가능해 고객 맞춤형(커스텀) HBM 생산에 유리하다는 게 이 사장의 설명이다. 삼성은 이 부품을 로직다이라고 부르는 반면 SK하이닉스는 베이스다이라고 명명하고 있다.

SK하이닉스는 이 문제에 대해 대만 TSMC와의 협업 확대를 돌파구로 제시했다. 김 사장은 기조 강연에서 “6세대 HBM인 HBM4부터는 TSMC와 협업해 고객사에 적기에 공급할 수 있도록 개발 작업이 순조롭게 진행되고 있다”고 했다. HBM은 베이스다이 위에 D램을 쌓는 방식으로 생산되며 기존에는 SK하이닉스가 직접 이 베이스다이를 만들었으나 6세대 제품부터는 TSMC에 생산을 맡겨 기능을 더욱 고도화한다는 전략이다.

양 사 모두 HBM 뒤를 잇는 차세대 메모리 제품에 대한 자신감도 내비쳤다. 김 사장은 “HBM4를 비롯해 저전력컴프레션어태치드메모리(LPCAMM), 컴퓨트익스프레스링크(CXL) 등에 대한 개발을 착실히 준비하고 있다”고 말했다. 이 제품들은 AI 시대 초고성능 메모리에 대한 수요가 늘어나면서 주목을 받고 있다. GPU와 같은 AI 가속기들의 성능이 급격히 발달하면서 연산 기능을 보조하는 메모리 성능에도 한계 돌파가 요구되고 있는 것이다.

우선 LPCAMM은 HBM의 단점인 높은 전력 소모와 발열 등의 문제를 해소하는 제품으로 볼 수 있다. 이 제품은 저전력D램(LPDDR)을 여러 개로 묶어 성능은 끌어올리면서 전력 효율은 개선시키는 장점을 갖고 있다. 삼성은 지난해 9월 업계 최초로 LPCAMM2를 개발했고 SK하이닉스는 두 달 뒤 초당 9.6Gb의 전송 속도를 지원하는 LPCAMM2를 공개한 바 있다.

CXL은 기존 메모리의 상식을 파괴하는 제품이다. 이 제품은 최근 출시되는 AI 모델의 파라미터(연산에 쓰이는 매개변수)가 수백억 개까지 불어나자 서랍처럼 분리된 메모리 공간을 서로 공유(pooling)할 수 있게 해주는 네트워크 기술을 기반으로 만들어졌다. HBM이 메모리를 수직으로 쌓아 연산 속도를 높였다면 CXL은 절대 용량 자체를 늘리는 기술인 셈이다.

AI 메모리 시장의 최대 난제로는 두 사람 모두 전력 효율 개선과 메모리 용량 확대의 어려움을 지목했다. 이 사장은 “생성형 AI를 훈련하는 데 막대한 전력이 소모되고 있다”며 “GPU의 계산 능력은 크게 증가했으나 메모리 대역폭은 이를 따라잡지 못해 AI 모델의 성능을 제한할 수 있다”고 설명했다.

김 사장도 “AI 시대 메모리는 전력 소모를 줄이면서 속도와 용량을 모두 끌어올려야 하는 난제를 안고 있다”며 “AI 칩 분야에서 글로벌 리더가 되기 위해 파트너들과 협력해 유리 기판, 액침 냉각 등 인프라 구축에 더욱 힘쓸 계획”이라고 강조했다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

squiz@sedaily.com

squiz@sedaily.com