카카오(035720)가 인공지능(AI) 기술 개발·운영 과정에서 발생할 수 있는 리스크를 관리하는 체계인 ‘카카오 AI 세이프티 이니셔티브(카카오 ASI)’를 구축했다고 23일 밝혔다.

카카오는 22일 경기 용인 ‘카카오 AI 캠퍼스’에서 열린 개발자 컨퍼런스 ‘이프카카오(if kakao AI 2024)’의 세션에서 이 같은 계획을 공개했다.

카카오 ASI는 AI 기술 개발 및 운영 상의 위험 발생을 최소화하고 안전하고 윤리적인 AI 시스템을 구축하기 위한 종합 지침이다. 기술 설계부터 개발, 테스트, 배포, 모니터링, 업데이트 등 AI 시스템의 전 생애주기에서 발생할 수 있는 리스크에 선제적인 대응이 가능한 게 특징이다. AI와 인간이 초래할 수 있는 다양한 종류의 리스크를 폭넓게 관리하고 인간의 부주의나 실수로 발생할 수 있는 영역까지 관리 범위를 포괄적으로 지정했다.

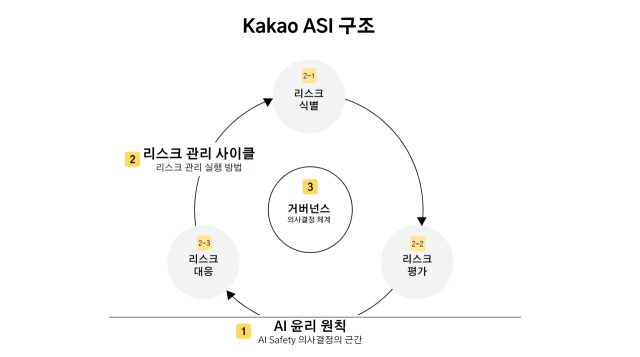

카카오 ASI는 △카카오 AI 윤리 원칙 △리스크 관리 사이클 △AI 리스크 거버넌스 등 세 가지 핵심 요소로 구성된다. 카카오 AI 윤리 원칙은 지난해 3월 발표한 ‘카카오 그룹의 책임 있는 AI를 위한 가이드라인’을 기반으로 개발자와 사용자에게 윤리적인 가이드라인을 제공한다. 리스크 관리 사이클은 AI 기술의 비윤리·불완전 등을 최소화하고 안전성과 신뢰성을 확보하기 위한 접근법이다. AI 리스크 거버넌스는 AI 시스템의 개발·배포·사용 등을 관리하고 감독하는 의사 결정 체계다.

카카오는 카카오 ASI 구축 이후에도 AI 기술 개발과 운영 과정에서 발견되는 리스크를 신속하게 식별 및 대응하고 지속적으로 체계 고도화를 이어갈 계획이라고 설명했다.

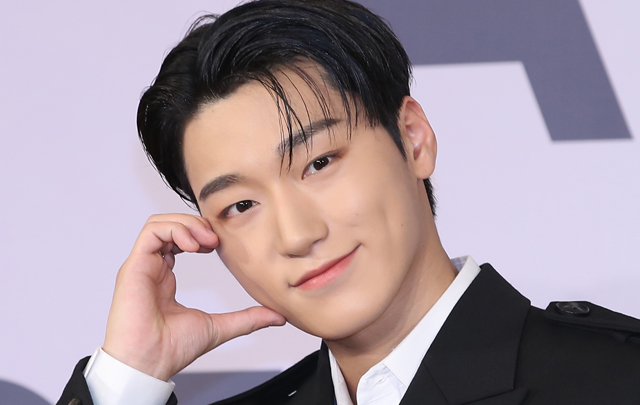

김경훈 카카오 AI 세이프티 리더는 “AI 시스템 이용에 따른 리스크의 발생 주체를 AI와 인간으로 구분하고 발생 주체별 리스크의 특성을 반영해 평가·대응방안을 마련했다는 점이 타사의 AI 리스크 관리 프레임워크와 차별화되는 점”이라며 “안전한 AI 생태계 조성을 위한 협력을 이어가고 카카오 ASI를 통해 윤리 기준을 선도해 나갈 수 있도록 노력할 것”이라고 말했다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

jin@sedaily.com

jin@sedaily.com