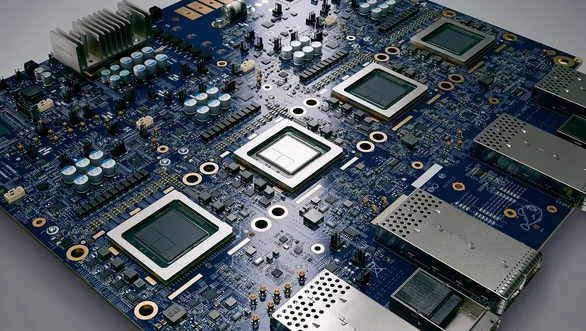

인공지능(AI) 반도체 시장의 흐름이 ‘맞춤형’ 시대로 접어들면서 메모리 시장에도 지각변동이 일어날 것으로 전망된다. 수년간 AI 메모리 업계를 지배했던 고대역폭메모리(HBM) 외에도 다양한 D램이 차세대 AI 칩으로 거론되기 시작하면서 SK하이닉스의 시장 독주에도 균열이 생길 수 있다.

2일 업계에 따르면 엔비디아가 독주하던 AI 반도체 시장에서 새로운 변화가 일어난 것은 ‘추론’ 시장이 고개를 들고 있기 때문이다. AI 반도체는 크게 학습용과 추론용으로 나뉜다. 학습용 반도체는 거대언어모델(LLM) 개발을 위해 방대한 데이터를 단순한 모델로 만들 때 활용된다.

엔비디아의 제품은 AI 학습용 반도체 시장에서 발군의 기량을 뽐내고 있다. 2022년 오픈AI가 챗GPT를 출시한 후 세계 도처에서 생성형 AI와 LLM 모델 ‘붐’이 일어나자 엔비디아 H시리즈처럼 학습에 최적화한 그래픽처리장치(GPU)가 불티나게 팔렸다.

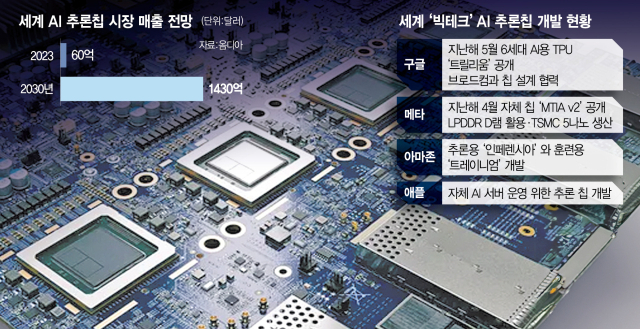

업계는 서서히 추론용 AI 칩을 더 주목하기 시작했다. 학습된 AI 모델을 AI 서비스에 본격적으로 응용하려는 움직임이 시작되면서다. 시장조사 업체 옴디아에 따르면 추론용 AI 칩 시장은 2023년 60억 달러에서 7년 뒤 2030년에는 1430억 달러(약 210조 원)까지 성장할 것으로 전망된다.

추론용 칩은 방대한 양을 처리하는 능력보다 전력 대비 성능, 이른바 ‘전성비’가 더 중요하다. 업계에서는 엔비디아 칩이 추론용 반도체에 적합한지에 대한 갑론을박이 있다. 가격이 너무 비싼데다 전력 소모가 매우 심해 응용처가 세부적으로 나눠지는 추론 시장에서는 매력이 떨어질 수 있다는 이유에서다. 지난해 하반기부터 GB200 등 최상위 제품군의 공급 문제까지 대두되고 있다.

빅테크 기업들은 자신들의 색깔에 맞춘 ASIC(맞춤형 칩) 개발에 속도를 올리고 있다. 구글은 지난해 5월 학습과 추론 모두 대응할 수 있는 AI 칩 ‘트릴리움’을 발표했다.

브로드컴이 주식시장에서 주목받는 이유도 여기에 있다. 구글·메타와 손잡고 각 고객사의 ASIC 개발을 지원하고 있다. 최근 실적 발표에서 “대형 클라우드 기업 3곳과 맞춤형 AI 칩을 개발하고 있다”고도 했다.

맞춤형 반도체 시장이 만개하면 메모리 시장의 모습도 크게 바뀔 수 있다. 엔비디아가 주도하고 있는 AI 칩 시장에서는 HBM이 군림하고 있다. 연산장치 바로 옆에서 고용량의 데이터를 저장할 수 있고 정보를 전송하는 속도 역시 상당히 빠르다. 삼성전자와 SK하이닉스가 올해 말 양산을 목표로 하고 있는 6세대 HBM(HBM4)은 정보 출입구 수가 전작 대비 2배 늘어난 2048개가 될 것으로 예상된다.

다만 추론의 시대가 다가오면서 비용과 전력 효율성까지 보장할 수 있는 새로운 메모리가 각광을 받고 있다. 모바일 기기에 활용되는 LPDDR 칩 등이 대표적이다. 메타의 추론 칩 ‘MTIA’는 HBM이 아닌 LPDDR 기반으로 설계됐다. 네이버가 지난해까지 삼성전자와 개발했던 ‘마하’ 칩도 좋은 예다.

범용 D램 모듈을 극대화하는 방안도 고려되고 있다. 컴퓨트익스프레스링크(CXL) D램이 대표적인데 데이터센터에 필요한 D램 모듈의 양을 무한정 늘릴 수 있는 표준으로 방대한 AI 데이터에 대응한다는 콘셉트다. 삼성전자와 SK하이닉스는 HBM의 변형과 함께 새로운 종류의 AI용 D램 개발에 속도를 내고 있는 것으로 알려졌다.

업계의 한 관계자는 “광 반도체(실리콘 포토닉스) 등 고차원적인 통신 기술이 발전하면 HBM과 범용 D램 사이의 경계가 허물어질 가능성도 있다”며 “HBM 외 다른 AI용 메모리 제품의 성장 가능성도 예의 주시해야 할 때”라고 설명했다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

hr@sedaily.com

hr@sedaily.com