한국정보통신기술협회(TTA)는 LLM 학습용 데이터에 대해 유해표현을 검출할 수 있는 AI모델을 구축했다고 3일 밝혔다. 해당 모델은 한국지능정보사회진흥원(NIA)의 2024년 초거대AI 학습용 데이터 품질검증 사업의 일환으로 개발됐다.

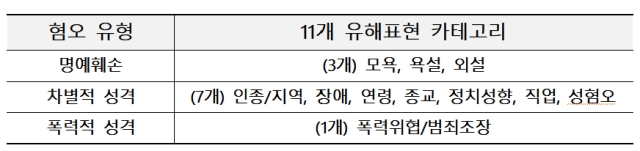

AI모델은 말뭉치 내 문장의 유해표현 여부를 우선 판단하고, 유해표현인 경우 카테고리를 분류해 말뭉치 유해성을 검출하게 된다. 유해 카테고리는 국가인권위원회의 혐오표현 정의 ‘혐오표현대항 안내서’와 ‘혐오표현 정의’ 등 3가지 유형별 총 11개로 설정됐다. 텍스트 문맥을 고려해 유해성을 분석하게 해 비속어가 포함되지 않는 유해표현도 검출할 수 있다.

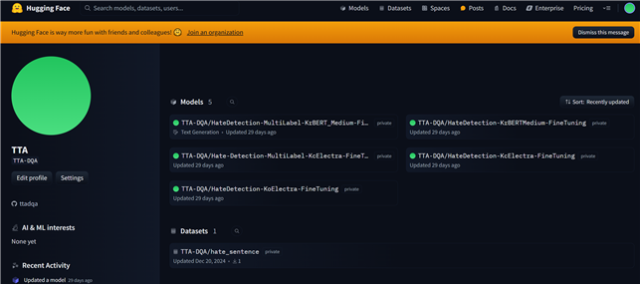

구축된 유해표현 검출 AI모델과 학습용 데이터는 오픈소스 라이브러리 및 AI 모델 배포 플랫폼인 허깅페이스에 업로드했다. 허깅페이스 API를 활용하면 누구나 손쉽게 모델을 통해 말뭉치 텍스트의 유해성을 분석하고 유해표현을 정제할 수 있다.

해당 모델은 단계별로 선정과정에서 고려됐던 버전(KoBERT Fine-Tuning)을 함께 업로드해 사용자가 골라 사용할 수 있다. 사용자는 모델 및 데이터 카드를 통해 세부 정보 및 테스트 결과를 확인하고 목적에 맞게 모델을 선택해 활용이 가능하다.

그간 생성형 AI 서비스의 신뢰성, 안전성 문제를 발생시켰던 학습용 말뭉치 데이터에 포함된 다양한 유해표현을 정제하는 것이 쉽지 않았다. 이번에 오픈소스로 공개한 유해표현 검출 AI 모델을 많이 이용해 더욱 안전하고 신뢰할 수 있는 AI사용기반이 정착될 것으로 기대된다.

손승현 TTA 회장은 “최근 다양한 분야에서 생성형 AI 기술이 활발히 적용돼 LLM 학습용 텍스트 데이터에 대한 수요가 급증하고 있다”며 “이에 따라 LLM 기술의 윤리적 측면에 대한 사회적 관심도 높아지고 있고 특히 학습용 텍스트에 포함된 유해 표현은 정제하는 과정이 반드시 필요하다”고 강조했다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

joist1894@sedaily.com

joist1894@sedaily.com